▀M(j©¼n)╚ļ2016─Ļęį║¾Ż¼╚▌Ų„╝╝ąg(sh©┤)įńęčĮø(j©®ng)Å─ūŅ│§Ą─┼Ż▒ŲØM╠ņ’wĄĮ┴╦─_╠żīŹ(sh©¬)ĄžĄ─┤¾ęÄ(gu©®)─Żõüķ_ĪŻ║▄ČÓŲ¾śI(y©©)Č╝ęčĮø(j©®ng)į┌īŹ(sh©¬)ļHĒŚ(xi©żng)─┐ųą╗“╔Ņ╗“£\Ą─╩╣ė├ų°╚▌Ų„╝╝ąg(sh©┤)Ż¼ŽĒ╩▄ĄĮą┬╝╝ąg(sh©┤)ĦüĒĄ─║å(ji©Żn)ØŹ║═Ė▀ą¦ĪŻū„×ķć°(gu©«)ā╚(n©©i)ūŅįń蹊┐║═╩╣ė├Docker╝╝ąg(sh©┤)Ą─Ų¾śI(y©©)Ż¼ThoughtWorksį┌2013─ĻĄūŠ═į┌īŹ(sh©¬)ļHĒŚ(xi©żng)─┐ųąīóDockerė├ė┌£y(c©©)įćŁh(hu©ón)Š│Ą─┘Yį┤Å═(f©┤)ė├Ż¼▓óį┌ų«║¾Ą─įSČÓĒŚ(xi©żng)─┐ųąųØu┐éĮY(ji©”)│÷įSČÓėąė├Ą─īŹ(sh©¬)█`║═Įø(j©®ng)“×(y©żn)ĪŻį┌▀@Ų¬╬─š┬└’Ż¼╬ęīó┴─┴─Dockerį┌╬ęĮø(j©®ng)Üv▀^ĒŚ(xi©żng)─┐ųąĄ─ę╗ą®▒╚▌^ėą┤·▒ĒąįĄ─▀\(y©┤n)ė├ł÷(ch©Żng)Š░ĪŻ

¼F(xi©żn)īŹ(sh©¬)ųąĄ─╚▌Ų„╝╝ąg(sh©┤)▀\(y©┤n)ė├ĘĮ╩ĮĘŪ│ŻÅVĘ║Č°ņ`╗ŅŻ¼Ģr(sh©¬)│Żūī╚╦ėXĄ├─XČ┤┤¾ķ_Ż¼Ė┼└©üĒšf╩ŪĪ║┐╔ąĪ┐╔┤¾Ż¼┐╔▀h(yu©Żn)┐╔Į³Ī╗ĪŻŽ┬├µė├╦─éĆ(g©©)░Ė└²üĒĻU╩Š╚▌Ų„į┌ĘŪ╠žČ©ŅI(l©½ng)ė“└’Ą─▀\(y©┤n)ė├ł÷(ch©Żng)Š░ĪŻ

╚▌Ų„ų«ąĪŻ║ąĪČ°├└Ą─╚▌Ų„DevOps╝▄śŗ(g©░u)ŚŻ

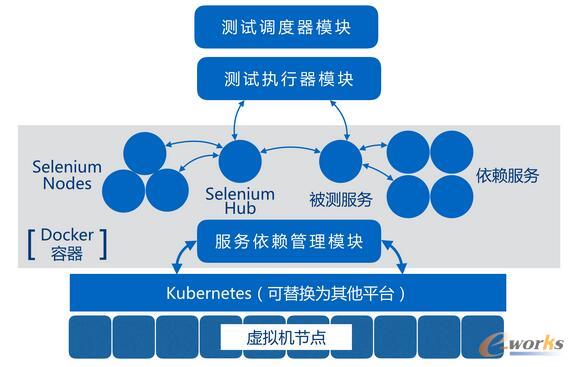

łD1 ╗∙ė┌╚▌Ų„║═DevOps└Ē─ŅĄ─▀\(y©┤n)ŠS╝▄śŗ(g©░u)

▀@Åł╝▄śŗ(g©░u)łDüĒūįė┌ę╗éĆ(g©©)ęÄ(gu©®)─Ż▓╗ĄĮ20╚╦Ą─ąĪą═«a(ch©Żn)ŲĘłF(tu©ón)ĻĀ(du©¼)Ż¼łF(tu©ón)ĻĀ(du©¼)Ą─ĮY(ji©”)śŗ(g©░u)╩«ĘųŠ½Ū╔Ż¼ė╔ā╔├¹ķ_░l(f©Ī)╚╦åT╝µ╚╬ų„ꬥ─▀\(y©┤n)ŠS╣żū„ĪŻ▀@ā╔╬╗ķ_░l(f©Ī)╚╦åTŻ¼╗©┴╦Äūų▄Ģr(sh©¬)ķg═©▀^AnsibleĻæĻæ└m(x©┤)└m(x©┤)┤ŅĮ©Ų┴╦▀@╠ūė╔╔Ž░┘éĆ(g©©)Ę■äš(w©┤)Ų„╣Ø(ji©”)³c(di©Żn)ĮM│╔Ą─╝»╚║Ż¼▓óė╔łF(tu©ón)ĻĀ(du©¼)╦∙ėąķ_░l(f©Ī)╚╦åT╣▓═¼ŠSūo(h©┤)ĪŻš¹¾w╠ū╝»╚║ŽĄĮy(t©»ng)Ė▀Č╚ūįäė(d©░ng)╗»Ż¼╩╣Ą├łF(tu©ón)ĻĀ(du©¼)Ą─├┐éĆ(g©©)╚╦Č╝─▄ē“╩«Ęų┐ņ╦┘Č°░▓╚½Ą─═Ļ│╔śI(y©©)äš(w©┤)╣”─▄Ą─▓┐╩Īó½@╚ĪŠĆ╔ŽśI(y©©)äš(w©┤)Ą─▀\(y©┤n)ąąĀŅørĪóęį╝░ī”(du©¼)│÷¼F(xi©żn)å¢Ņ}Ą─╣╩šŽ³c(di©Żn)▀M(j©¼n)ąą┐ņ╦┘Ą─╚šųŠÕe(cu©░)š`Č©╬╗ĪŻ

┬ķ╚ĖļmąĪŻ¼╬Õ┼KŠŃ╚½ĪŻ▀@╠ū╝╝ąg(sh©┤)ĘĮ░Ė░³║¼┴╦╝»╚║╣▄└ĒĪóŠW(w©Żng)Įj(lu©░)╣▄└ĒĪóĘ■äš(w©┤)░l(f©Ī)¼F(xi©żn)Īó╚šųŠ╣▄└ĒĪóąį─▄▒O(ji©Īn)┐žĄ╚įSČÓĘĮ├µĄ─įO(sh©©)ėŗ(j©¼)Ż¼Å─╝▄śŗ(g©░u)Ą─ĮŪČ╚╔Ž┐┤Ż¼ęčĮø(j©®ng)ā░╚╗╩Ūę╗éĆ(g©©)ąĪą═╦ĮėąPaaSŲĮ┼_(t©ói)ĪŻ

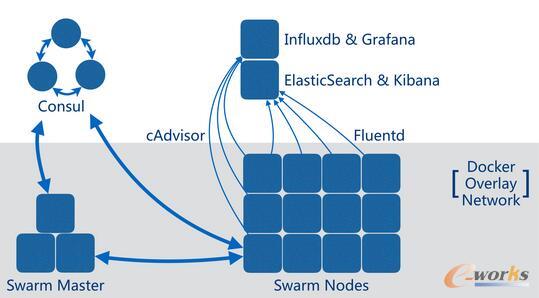

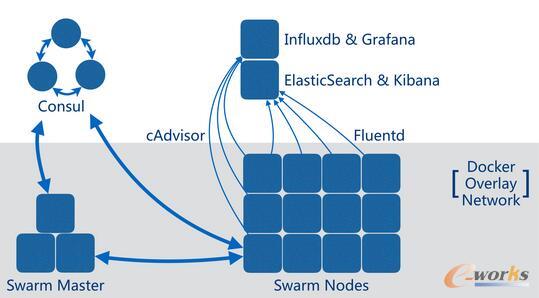

Swarmū„×ķ╝»╚║Ą─╣▄└Ē╣żŠ▀Ż¼Š▀ėą┼cDockerįŁ╔·├³┴Ņ┴╝║├Ą─ę╗ų┬ąįŻ¼į┌īW(xu©”)┴Ģ(x©¬)Ū·ŠĆ▒╚▌^ŠÅ║═Ż¼į┌DevOps╬─╗»▒╚▌^║├Ą─łF(tu©ón)ĻĀ(du©¼)ųą║▄╚▌ęūūīķ_░l(f©Ī)╚╦åT┐ņ╦┘╔Ž╩ųĪŻį┌▀@éĆ(g©©)╝▄śŗ(g©░u)ĘĮ░Ėųą╩╣ė├┴╦Consulū„×ķ╝»╚║į¬öĄ(sh©┤)ō■(j©┤)┤µā”(ch©│)Ą─ĘĮ░ĖŻ¼SwarmĄ─ų„ĪóÅ─╣Ø(ji©”)³c(di©Żn)ą┼Žóęį╝░DockerĄ─┐ń╣Ø(ji©”)³c(di©Żn)ŠW(w©Żng)Įj(lu©░)äØĘųĄ─ą┼ŽóČ╝┤µĘ┼į┌▀@└’ĪŻConsul│²┴╦ū„×ķ╝»╚║ą┼ŽóĄ─┤µā”(ch©│)Ż¼▀Ć┐╔ęįė├ė┌æ¬(y©®ng)ė├Ę■äš(w©┤)Ą─┼õų├┤µā”(ch©│)║═Ę■äš(w©┤)░l(f©Ī)¼F(xi©żn)Ż¼ęį╝░ū„×ķā╚(n©©i)ŠW(w©Żng)Ą─DNSĘ■äš(w©┤)╩╣ė├ĪŻ▓╗▀^│÷ė┌░▓╚½ąį║═┐╔ŠSūo(h©┤)ąįĄ─┐╝æ]Ż¼æ¬(y©®ng)įō×ķæ¬(y©®ng)ė├Ę■äš(w©┤)å╬¬Ü(d©▓)┤ŅĮ©¬Ü(d©▓)┴óĄ─Consul╣Ø(ji©”)³c(di©Żn)Ż¼┼c┤µā”(ch©│)╝»╚║┼õų├Ą─ConsulĘųķ_Ż¼Ę└ų╣ė╔ė┌öĄ(sh©┤)ō■(j©┤)Ė╔ö_║═ęŌ═Ōą▐Ė─ę²Ų┤¾ęÄ(gu©®)─ŻŽĄĮy(t©»ng)╣╩šŽĪŻ

╩╣ė├SwarmĄ─┴Ēę╗éĆ(g©©)Øōį┌║├╠Ä╩Ū╦³─▄ē“│õĘų└¹ė├Dockerā╚(n©©i)ų├Ą─┐ń╣Ø(ji©”)³c(di©Żn)ŠW(w©Żng)Įj(lu©░)╣”─▄Ż¼▀@╠ū╗∙ė┌VxLANĄ─SDNīŹ(sh©¬)¼F(xi©żn)╩«Ęų║å(ji©Żn)ØŹęūė├Ż¼═©ą┼ą¦┬╩ę▓║▄▓╗Õe(cu©░)ĪŻ

╚▌Ų„╝»╚║Ą─Ą─ąį─▄▒O(ji©Īn)┐ž║═╚šųŠ╣▄└Ē╩Ū╩╣Ą├▀@éĆ(g©©)ąĪłF(tu©ón)ĻĀ(du©¼)Ą├ęį±{±S▒╚łF(tu©ón)ĻĀ(du©¼)╚╦öĄ(sh©┤)Ė³ČÓĄ─Ę■äš(w©┤)╣Ø(ji©”)³c(di©Żn)Ą─ĻP(gu©Īn)µIę¬╦žŻ¼╚╬æ{▀\(y©┤n)ąąĄ─Ę■äš(w©┤)į┌ÖC(j©®)Ų„┬■┬■║Żč¾ųąļSęŌ┤®ąąŻ¼▀@ā╔╝■╣żŠ▀Š═╩Ūķ_░l(f©Ī)╚╦åTĄ─┴_▒P║═’L(f©źng)Ž“ś╦(bi©Īo)Ż¼į┌ĻP(gu©Īn)µIĢr(sh©¬)║“?y©żn)ķŠĆ╔Ž╣╩šŽĄ─Č©╬╗ĀÄ(zh©źng)╚ĪīÜ┘FĢr(sh©¬)ķgŻ¼▓ó─▄Å─ųąčĖ╦┘šęĄĮ├┐éĆ(g©©)Ę■äš(w©┤)«ö(d©Īng)Ū░▀\(y©┤n)ąąĄ─╣Ø(ji©”)³c(di©Żn)Ż¼Å─Č°▓╔╚Ī▒žę¬Ą─æ¬(y©®ng)╝▒┤ļ╩®ĪŻcAdvisor+Influxdb+Grafana╩Ūę╗╠ū×ķ╚▌Ų„╝»╚║ąį─▄▒O(ji©Īn)┐žįO(sh©©)ėŗ(j©¼)Ą─ķ_į┤ĮŌøQĘĮ░ĖŻ¼└¹ė├cAdvisorī”(du©¼)╚▌Ų„ą┼ŽóĄ─┴╝║├▒O(ji©Īn)┐ž─▄┴”Ż¼Influxdbī”(du©¼)Ģr(sh©¬)ķgą“┴ąöĄ(sh©┤)ō■(j©┤)Ą─┐ņ╦┘Öz╦„─▄┴”Ż¼ęį╝░GrafanaĄ─ÅŖ(qi©óng)┤¾łD▒Ēš╣╩Š─▄┴”Ż¼ą╬│╔ąį─▄öĄ(sh©┤)ō■(j©┤)Ą─īŹ(sh©¬)Ģr(sh©¬)▓ķ┐┤║═Üv╩Ę╗ž╦▌Ż¼▓óĘ┤üĄĮķ_░l(f©Ī)║═▀\(y©┤n)ĀI(y©¬ng)Ą─ĀŅæB(t©żi)ł¾(b©żo)▒ĒŻ¼ą╬│╔═Ļš¹ķ]Łh(hu©ón)ĪŻ▓╗▀^Ż¼▀@éĆ(g©©)ķ_į┤ĮM║ŽĄ─╚▒Ž▌į┌ė┌╚▒Ę”¼F(xi©żn)│╔Ą─╩┬╝■ĖµŠ»ĮM╝■Ż¼į┌Influxdata╣½╦ŠĄ─TelegrafĒŚ(xi©żng)─┐ųØu│╔╩ņ║¾Ż¼┐╔ęį┐╝æ]╩╣ė├╦³╠µ┤·cAdvisorĄ─╣”─▄Ż¼╚╗║¾╝»│╔Kapacitorū„×ķĖµŠ»─ŻēKŻ¼╠ßŪ░ŅA(y©┤)ų¬Ę■äš(w©┤)Ą─▓╗š²│ŻĀŅæB(t©żi)ĪŻ╚šųŠ╣▄└ĒĘĮ├µŻ¼▀@╠ūŽĄĮy(t©»ng)╩╣ė├┴╦«ö(d©Īng)Ž┬ūŅų„┴„Ą─╚▌Ų„╚šųŠķ_į┤╣żŠ▀ĮM║ŽFluentd+EslasticSearch+KibanaŻ¼į┌ĪČ│╠ą“åTĪĘ2016─Ļ6į┬┐»Ī║╚▌Ų„Ą─ąį─▄▒O(ji©Īn)┐ž║═╚šųŠ╣▄└ĒĪ╗ę╗╬─ųąęčĮø(j©®ng)ī”(du©¼)▀@éĆ(g©©)ĮM║Ž▀M(j©¼n)ąą▀^▒╚▌^╔Ņ╚ļĄ─╠ĮėæĪŻ

▀@╩ŪDocker╝»╚║╗»īŹ(sh©¬)█`ųą▀\(y©┤n)ė├Ą├▒╚▌^│÷╔½Ą─ę╗éĆ(g©©)░Ė└²Ż¼╠žäe╩Ūī”(du©¼)ųąąĪą═«a(ch©Żn)ŲĘłF(tu©ón)ĻĀ(du©¼)Ż¼Ģ■(hu©¼)ėą▓╗╔┘┐╔ĮĶĶb║═åó░l(f©Ī)ų«╠ÄĪŻį┌▓╗ė├į÷╝ėŅ~═Ō▀\(y©┤n)ŠS╚╦åTĄ─ŪķørŽ┬Ż¼▀@╠ūŽĄĮy(t©»ng)┐╔ęį▒╚▌^▌p╦╔Ą─öU(ku©░)╚▌ų┴Äū░┘╔ŽŪ¦Ą─ęÄ(gu©®)─ŻĪŻ╚╗Č°Ż¼▀@éĆ(g©©)╝▄śŗ(g©░u)▒Š╔Ē▓óø]ėą┐╝æ]Ų®╚ńČÓöĄ(sh©┤)ō■(j©┤)ųąą─ĪóūŌæ¶Ė¶ļxĪóįLå¢╩┌ÖÓ(qu©ón)Īó┘Yį┤┼õŅ~Ą╚Å═(f©┤)ļsŪķŠ░Ż¼╦³ų„ꬥ─įO(sh©©)ėŗ(j©¼)│§ųįį┌ė┌ĮŌøQ╝»╚║ęūė├ąįĄ─å¢Ņ}ĪŻįćŽļį┌▀^╚ź╩╣ė├╠ōöMÖC(j©®)╣▄└ĒĘ■äš(w©┤)Ą─Ģr(sh©¬)┤·Ż¼ūīų╗ėąÄūéĆ(g©©)╚╦Ą─łF(tu©ón)ĻĀ(du©¼)╚źŠSūo(h©┤)╔ŽŪ¦éĆ(g©©)ėŗ(j©¼)╦Ń╣Ø(ji©”)³c(di©Żn)╔Ž▀\(y©┤n)ąąĄ─ąĶę¬Ė„ĘN▓╗═¼Łh(hu©ón)Š│║═┼õų├Ą─Ę■äš(w©┤)Ż¼▀@║å(ji©Żn)ų▒╩Ū▓╗┐╔═Ļ│╔Ą─╚╬äš(w©┤)Ż¼╚╗Č°═©▀^╚▌Ų„╗»Ą─▓┐╩ĪóDevOps╦╝ŠSĄ─łF(tu©ón)ĻĀ(du©¼)Īó╝ė╔Ž▀m«ö(d©Īng)?sh©┤)─╝»╚║▌oų·╣żŠ▀Ż¼╦¹éāū÷ĄĮ┴╦ĪŻ

╚▌Ų„ų«┤¾Ż║┤¾ą═╚╬äš(w©┤)╝»╚║Ą─╚▌Ų„╗»š{(di©żo)Č╚

łD2 ╗∙ė┌╚▌Ų„Ą─ČÓöĄ(sh©┤)ō■(j©┤)ųąą─╚╬äš(w©┤)ŲĮ┼_(t©ói)╝▄śŗ(g©░u)

▓ó▓╗╩Ū╦∙ėąĄ─łF(tu©ón)ĻĀ(du©¼)Č╝įĖęŌÅ─Ņ^śŗ(g©░u)Į©ūį╝║Ą─š¹╠ū▀\(y©┤n)ŠS╝▄śŗ(g©░u)║═╗∙ĄA(ch©│)įO(sh©©)╩®Łh(hu©ón)Š│ĪŻį┌įSČÓŲ¾śI(y©©)└’Ż¼Ę■äš(w©┤)Ą─▀\(y©┤n)ŠS╣▄└Ē╩ŪėąīŻķTĄ─ĮM┐Śžō(f©┤)ž¤(z©”)Ą─ĪŻ▀@ą®ĮM┐Ś┐╔─▄Įąū÷ŲĮ┼_(t©ói)▓┐ķTĪó▀\(y©┤n)ŠS▓┐ķTĪó╗“š▀Łh(hu©ón)Š│ų¦│ų▓┐ķTŻ¼▓╗šōĘQ║¶╚ń║╬Ż¼▀@ą®ĮM┐Śęį╝░▓┐ķT═©│ŻČ╝ąĶę¬╣▄└ĒöĄ(sh©┤)┴┐ŽÓ«ö(d©Īng)²ŗ┤¾Ą─ėŗ(j©¼)╦Ń┘Yį┤ĪŻ▀@ą®┘Yį┤┐╔─▄╩Ū┐ńÖC(j©®)Ę┐Ż¼┐ń│Ū╩ąŻ¼╔§ų┴╩ŪĘų▓╝į┌ÜWų▐Īó├└ų▐ĪóĘŪų▐▓óŪęŽÓ╗ź¤oĘ©ų▒Įė═©ą┼Ą─öĄ(sh©┤)ō■(j©┤)ųąą─└’ĪŻ╦¹éā╦∙ąĶ꬚{(di©żo)Č╚Ą─ū„śI(y©©)öĄ(sh©┤)┴┐║═ĘNŅÉę▓▀h(yu©Żn)▀h(yu©Żn)│¼▀^ę╗éĆ(g©©)ūį▀\(y©┤n)ŠS«a(ch©Żn)ŲĘłF(tu©ón)ĻĀ(du©¼)╦∙ąĶę¬┐╝æ]Ą─ęÄ(gu©®)─ŻĪŻ

×ķ▀@śėĄ─ĮM┐ŚįO(sh©©)ėŗ(j©¼)╗∙ė┌╚▌Ų„Ą─╚╬äš(w©┤)š{(di©żo)Č╚ŲĮ┼_(t©ói)ąĶę¬ī”(du©¼)Ų¾śI(y©©)Ą─ąĶŪ¾║═╠žČ©śI(y©©)äš(w©┤)ŅI(l©½ng)ė“ėą│õĘųĄ─┴╦ĮŌŻ¼įĮ╩Ū┤¾ą═Ą─╗∙ĄA(ch©│)įO(sh©©)╩®╝»╚║Ż¼╦∙ąĶę¬æ¬(y©®ng)ī”(du©¼)Ą─’L(f©źng)ļU(xi©Żn)║═▓╗┤_Č©ę▓įĮ┤¾Ż¼įO(sh©©)ėŗ(j©¼)ę╗éĆ(g©©)├µ├µŠŃĄĮĄ─═©ė├┤¾ą═╝»╚║ę▓įĮ└¦ļyĪŻę“┤╦ßśī”(du©¼)Š▀¾wśI(y©©)äš(w©┤)ł÷(ch©Żng)Š░ū÷│÷ę╗Č©Ą─╚Ī╔ß╩Ū▓╗Ą├ęčĪóĄ½ėų╩Ū▒žę¬Ą─ĪŻ└²╚ń×ķ┴╦½@Ą├▌^Ė▀Ą─Ēææ¬(y©®ng)╦┘Č╚Č°īó╝»╚║äØĘų×ķČÓéĆ(g©©)╗ź▓╗ųž»BĄ─š{(di©żo)Č╚ģ^(q©▒)ė“Ż¼ę“Č°Ž▐ųŲ┴╦├┐éĆ(g©©)ģ^(q©▒)ė“Ą─╚▌┴┐Ż╗×ķ┴╦▒▄├Ōā╚(n©©i)ŠW(w©Żng)öĄ(sh©┤)ō■(j©┤)ŠW(w©Żng)Įj(lu©░)’L(f©źng)▒®Č°īó╣Ø(ji©”)³c(di©Żn)öĄ(sh©┤)ō■(j©┤)Ęųīė╠Ä└Ē▓óų╝ē(j©¬)£p╔┘öĄ(sh©┤)ō■(j©┤)ģR┐éĄ─ŠSČ╚Ż¼ę“Č°į÷╝ė▒O(ji©Īn)┐ž╣▄└ĒÅ═(f©┤)ļsČ╚Ż╗╗“š▀×ķ┴╦į÷╝ėŽĄĮy(t©»ng)ęÄ(gu©®)─ŻČ°▓╔ė├Ė▀Č╚Š█║ŽČ°▓╗▀m║ŽČÓöĄ(sh©┤)ō■(j©┤)ųąą─Ą─ĘĮ░ĖĪŻ▀@ą®ĘĮ░Ė═∙═∙▓╗ąĶꬊ▀éõŲš▀mąįŻ¼Č°╩ŪĢ■(hu©¼)ßśī”(du©¼)╠žČ©Ų¾śI(y©©)║═śI(y©©)äš(w©┤)ł÷(ch©Żng)Š░▀M(j©¼n)ąąŪĪĄĮ║├╠ÄĄ─ą▐╝¶║═ā×(y©Łu)╗»ĪŻ

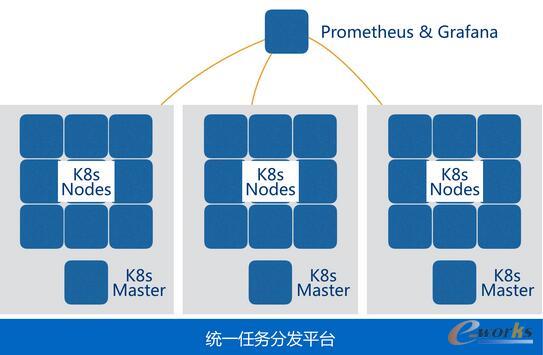

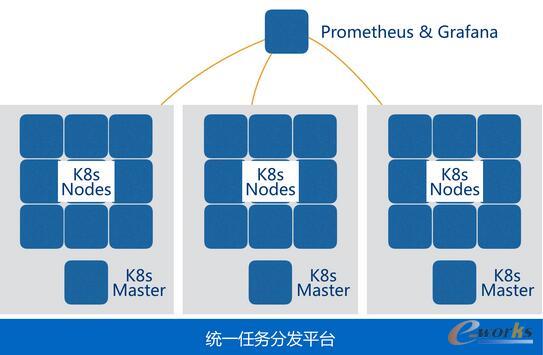

╔Ž├µłDųąš╣╩ŠĄ─╩Ūę╗éĆ(g©©)Ų¾śI(y©©)PaaSĘ■äš(w©┤)ŲĮ┼_(t©ói)Ą─ĮY(ji©”)śŗ(g©░u)Ż¼╝▄śŗ(g©░u)╗∙ė┌Kubernetes╝»╚║Ż¼ąĶę¬æ¬(y©®ng)ė├į┌ČÓéĆ(g©©)«ÉĄž?c©ói)?sh©┤)ō■(j©┤)ųąą─Ż¼▓óį┌Įy(t©»ng)ę╗Ą─▓┐╩ŽĄĮy(t©»ng)╔Žī”(du©¼)Ę■äš(w©┤)▀M(j©¼n)ąą╣▄└ĒĪŻė╔ė┌å╬Kubernetes╝»╚║╚▌┴┐ėąŽ▐Ż¼▀@éĆ(g©©)ĘĮ░ĖīŹ(sh©¬)ļH╔ŽĖ∙ō■(j©┤)Ąžė“äØĘų║═ūŌæ¶Ą─ęÄ(gu©®)─Żśŗ(g©░u)Į©┴╦ČÓéĆ(g©©)Äū╩«ĄĮ╔ŽŪ¦╣Ø(ji©”)³c(di©Żn)▓╗Ą╚Ą─ūė╝»╚║Ż¼╝»╚║ų▒Įė╗ź▓╗ųž║ŽŻ¼ī┘ė┌═¼ę╗éĆ(g©©)╚╬äš(w©┤)ĮMĄ─Ę■äš(w©┤)ų╗Ģ■(hu©¼)į┌╠žČ©Ą──│éĆ(g©©)╝»╚║ā╚(n©©i)▀M(j©¼n)ąą▓┐╩║═š{(di©żo)Č╚Ż¼ŲõīŹ(sh©¬)Š═╩Ūīó╝»╚║║═ūŌæ¶▀M(j©¼n)ąą┴╦ĮēČ©ĪŻį┌╦∙ėą╝»╚║ų«╔ŽŻ¼═©▀^ūį蹥─ę╗éĆ(g©©)╚╬äš(w©┤)Ęų░l(f©Ī)Ę■äš(w©┤)ū„×ķ╦∙ėąš{(di©żo)Č╚╚╬äš(w©┤)Ą─╚ļ┐┌Ż¼į┌▀@└’╠Ä└ĒĘ■äš(w©┤)Ą─ę└┘ćĻP(gu©Īn)ŽĄĪó╦∙ī┘ģ^(q©▒)ė“Īóęį╝░Ųõ╦¹į¬öĄ(sh©┤)ō■(j©┤)ą┼ŽóŻ¼╚╗║¾š{(di©żo)ė├KubernetesĄ─API═Ļ│╔╚╬äš(w©┤)Ą─▓┐╩║═š{(di©żo)Č╚Ż¼▓ó═©▀^Ņ~═ŌĄ─ĮM╝■╠Ä└ĒŠW(w©Żng)Įj(lu©░)Īó┤µā”(ch©│)Ą╚┘Yį┤Ą─┼õų├ĪŻ

į┌łDųą╩Ī┬į┴╦ŽĄĮy(t©»ng)▓╔ė├Ą─Ųõ╦¹ūįčą─ŻēKŻ¼ųĄĄ├ę╗╠ߥ─╩Ū▀@éĆ(g©©)ŽĄĮy(t©»ng)Ą─ąį─▄öĄ(sh©┤)ō■(j©┤)╣▄└Ē╩╣ė├┴╦ķ_į┤Ą─Promethus▄ø╝■ĪŻPromethus╩ŪSoundCloud╣½╦ŠŠSūo(h©┤)Ą─ę╗┐Ņ░³║¼ą┼Žó▓╔╝»Īó╠Ä└ĒĪóĘų╬÷Īóš╣╩Š║═ĖµŠ»Ą─ąį─▄▒O(ji©Īn)┐žš¹¾wĮŌøQĘĮ░ĖŻ¼╦³╠ß╣®┴╦▒╚▌^ņ`╗ŅĄ─ČÓöĄ(sh©┤)ō■(j©┤)ųąą─╝ē(j©¬)┬ō(li©ón)─▄┴”║═╝»ųą╩ĮĄ─┼õų├╣▄└Ē╣”─▄Ż¼ę“┤╦╠žäe▀m║ŽęÄ(gu©®)─Ż▌^┤¾Ą─ėŗ(j©¼)╦Ń╝»╚║ĪŻ▓╗═¼ė┌Ū░ę╗░Ė└²ųąInfluxdbĘĮ░Ė├┐éĆ(g©©)öĄ(sh©┤)ō■(j©┤)▓╔╝»╣Ø(ji©”)³c(di©Żn)░l(f©Ī)öĄ(sh©┤)ō■(j©┤)Įo┤µā”(ch©│)öĄ(sh©┤)ō■(j©┤)Ą─ųąą─╣Ø(ji©”)³c(di©Żn)Ą─ĘĮ╩ĮŻ¼PromethusĄ─ąį─▄öĄ(sh©┤)ō■(j©┤)▓╔╝»╩Ūė╔ųąą─Ę■äš(w©┤)Ų„ų„äė(d©░ng)Ž“╦∙ėą╣Ø(ji©”)³c(di©Żn)Č©Ģr(sh©¬)▌åįāĄ─ĘĮ╩Į└Ł╚ĪĄ─Ż¼ę“┤╦╦∙ėą┼cöĄ(sh©┤)ō■(j©┤)▓╔╝»ŽÓĻP(gu©Īn)Ą─┼õų├╚½▓┐į┌ųąą─Ę■äš(w©┤)Ų„╔Ž▀M(j©¼n)ąąą▐Ė─╝┤┐╔ĪŻČ°╣Ø(ji©”)³c(di©Żn)Ą─öĄ(sh©┤)┴┐║═IPĄžųĘūāäė(d©░ng)ät═©▀^Ę■äš(w©┤)░l(f©Ī)¼F(xi©żn)ÖC(j©®)ųŲüĒĖµų¬ųąą─Ę■äš(w©┤)Ų„Ż¼▀@┤¾┤¾║å(ji©Żn)╗»┴╦ą▐Ė─öĄ(sh©┤)ō■(j©┤)╩š╝»ģóöĄ(sh©┤)Ą─┴„│╠ĪŻ

▀@éĆ(g©©)░Ė└²╩Ūę╗éĆ(g©©)▒╚▌^Ąõą═Ą─┤¾ęÄ(gu©®)─Ż╚▌Ų„╝»╚║Ż¼į┌┤¾ą═╚▌Ų„╝»╚║ĘĮ├µįSČÓŲ¾śI(y©©)Č╝ėąų°ūį╝║Ą─īŹ(sh©¬)█`│┴ĄĒĪŻŲõųąėąā╔éĆ(g©©)▒╚▌^├„’@Ą─╠ž³c(di©Żn)╩ŪÅ─śI(y©©)äš(w©┤)ł÷(ch©Żng)Š░ųŲČ©╝▄śŗ(g©░u)║═ŽĄĮy(t©»ng)ųą░³║¼įSČÓūį蹥─ĮM╝■Ż¼ę“┤╦į┌ĮĶĶbĄ─Ģr(sh©¬)║“Ė³ąĶę¬ÅVĘ║Ą─╩š╝»ą┼ŽóŻ¼▒▄├Ō├ż─┐šš░ßĪŻ

╚▌Ų„ų«▀h(yu©Żn)Ż║╗∙ė┌╚▌Ų„Ą─│ų└m(x©┤)╝»│╔īŹ(sh©¬)█`

łD3 ╗∙ė┌╚▌Ų„Ą─│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆ╩ŠęŌ

ĮėŽ┬üĒŻ¼ūī╬ęéāė├ÅVĮŪńRŅ^üĒīÅęĢę╗Ž┬▄ø╝■░l(f©Ī)▓╝Ą─╔·├³ų▄Ų┌ĪŻ═©▀^│ų└m(x©┤)Į╗ĖČĄ─┴„╦«ŠĆŻ¼╬ęéā─▄ē“ŪÕ╬·Ą─Č©┴x│÷▄ø╝■Å─┤·┤a╠ßĮ╗ĄĮ╔ŽŠĆ░l(f©Ī)▓╝ų«Ū░╦∙ąĶę¬Įø(j©®ng)▀^Ą─├┐éĆ(g©©)Łh(hu©ón)╣Ø(ji©”)Ż¼ģf(xi©”)ų·ķ_░l(f©Ī)š▀░l(f©Ī)¼F(xi©żn)╣żū„┴„│╠ųą┤µį┌Ą─Ų┐ŅiŻ¼▓ó┤┘╩╣łF(tu©ón)ĻĀ(du©¼)╠ß╔²Č╦ĄĮČ╦Ą─ūįäė(d©░ng)╗»│╠Č╚Ż¼┐sČ╠¬Ü(d©▓)┴ó╣”─▄╔ŽŠĆĄ─ų▄Ų┌ĪŻ

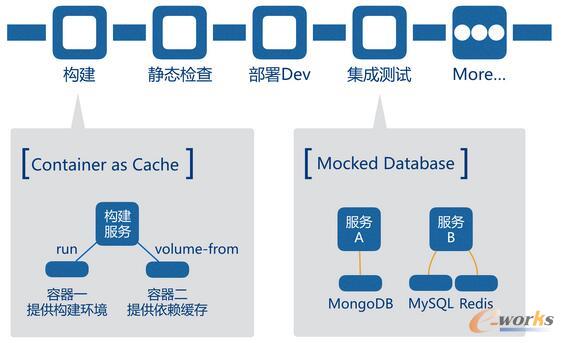

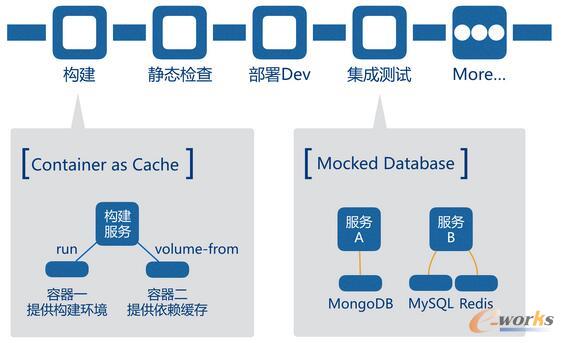

─Ū├┤╚▌Ų„į┌Ųõųą─▄░ńč▌╩▓├┤śėĄ─ĮŪ╔½─žŻ┐╩ūŽ╚╩Ū┘Yį┤Ą─Ė¶ļxŻ¼×ķ┴╦┤_▒Ż├┐ę╗┤╬ŠÄūg║═£y(c©©)įćĄ─¬Ü(d©▓)┴óąįŻ¼▄ø╝■æ¬(y©®ng)įōį┌Ė╔ā¶Ą─Łh(hu©ón)Š│ųąĘųäe▀M(j©¼n)ąąśŗ(g©░u)Į©Īó┤“░³Īó▓ó▀\(y©┤n)ąą£y(c©©)įćė├└²Ż¼Č°╚▌Ų„╩ŪĘŪ│Ż║Ž▀mė├üĒ╠ß╣®▀@ĘN╠ōöMŁh(hu©ón)Š│Ą─▌p┴┐╝ē(j©¬)╣żŠ▀ĪŻŲõ┤╬╩Ūę╗ų┬Ą─▄ø╝■┤“░³ĘĮ╩ĮŻ¼DockerĄ─ĘŌčbęŌ╬Čų°▓╗šō▀\(y©┤n)ąąĄ─Ę■äš(w©┤)╩Ūė├JavaĪóPythonĪóPHP▀Ć╩ŪScalaĪóGolangŻ¼ŲĮ┼_(t©ói)┐╔ęįė├Äū║§ŽÓ═¼Ą─ĘĮ╩Į╚ź═Ļ│╔▓┐╩Ż¼Č°▓╗ė├┐╝æ]░▓čbĘ■äš(w©┤)╦∙ąĶĄ─Łh(hu©ón)Š│Ż¼▀@ą®Č╝į┌▄ø╝■ķ_░l(f©Ī)Ą─Ģr(sh©¬)║“Š═ęčĮø(j©®ng)£╩(zh©│n)éõ║├┴╦ĪŻūŅ║¾╩Ū│╔╩ņĄ─š{(di©żo)Č╚ŲĮ┼_(t©ói)ĪŻ╗∙ė┌╚▌Ų„ėąįSČÓ¼F(xi©żn)│╔Ą─╚╬äš(w©┤)š{(di©żo)Č╚┐“╝▄Ż¼ę▓š²╩Ūė╔ė┌Ū░ā╔éĆ(g©©)ĮŪ╔½Ż¼╚▌Ų„╩╣Ą├╚╬äš(w©┤)Ą─Ęų░l(f©Ī)ūāĄ├╚▌ęūŻ¼ė╔ė┌æ¬(y©®ng)ė├▓╗ąĶę¬ę└┘ćų„ÖC(j©®)Ą─┼õų├Ż¼▀@Š═ūī╚╬äš(w©┤)Ą─ņ`╗Ņš{(di©żo)Č╚│╔×ķ┐╔─▄ĪŻ

╗∙ė┌╚▌Ų„Ą─│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆ║═Ųš═©Į╗ĖČ┴„╦«ŠĆ║▄ŽÓ╦ŲŻ¼░³║¼śŗ(g©░u)Į©Īó┤“░³Īó£y(c©©)įćĪó▓┐╩Ą╚Łh(hu©ón)╣Ø(ji©”)ĪŻ═¼Ģr(sh©¬)▀@Ųõųąę▓ėąįSČÓ╝╝Ū╔║═īŻė├ė┌╚▌Ų„Ą─ā×(y©Łu)╗»╩ųČ╬ĪŻ▀@éĆ(g©©)░Ė└²ųą╬ęéā▀x╚ĪŲõųąā╔éĆ(g©©)▒╚▌^Š▀ėąåó░l(f©Ī)ąįĄ─üĒšfĪŻ

Ą┌ę╗éĆ(g©©)└²ūė╩ŪĻP(gu©Īn)ė┌╚▌Ų„śŗ(g©░u)Į©Ą─ā×(y©Łu)╗»ĪŻ╚▌Ų„Ą─śŗ(g©░u)Į©═©│ŻČ╝╩Ūė╔─│éĆ(g©©)╗∙ĄA(ch©│)ńRŽ±ķ_╩╝Ż¼═©▀^DockerfileĄ─├Ķ╩÷ūįäė(d©░ng)╗»ų▓Įł╠(zh©¬)ąąŻ¼ų▒ų┴═Ļ│╔ŅA(y©┤)Ų┌Ą─ĀŅæB(t©żi)ĪŻÄū║§╦∙ėąĒŚ(xi©żng)─┐Ą─DockerfileČ╝▓╗Ģ■(hu©¼)├┐┤╬Å─ę╗éĆ(g©©)įŁ╩╝Ą─Ubuntu╗“š▀CentOSĄ─ńRŽ±ū÷×ķ╗∙ĄA(ch©│)Ż¼Å─Ņ^śŗ(g©░u)Į©š¹éĆ(g©©)▀\(y©┤n)ąąŁh(hu©ón)Š│Ż¼ę“?y©żn)ķ─ŪśėĢ?hu©¼)╩╣Ą├├┐┤╬śŗ(g©░u)Į©╗©┘M(f©©i)ĘŪ│ŻķL(zh©Żng)Ą─Ģr(sh©¬)ķgĪŻųŲū„ė├ė┌└^│ąĄ─╣½╣▓╗∙ĄA(ch©│)ńRŽ±╩Ūįńęč╩└╚╦Įįų¬Ą─ńRŽ±śŗ(g©░u)Į©╠ß╦┘ā×(y©Łu)╗»Ą─ĘĮĘ©Ż¼▀@śė┐╔ęįūī┘M(f©©i)Ģr(sh©¬)Č°ėų▓╗│ŻĖ─ūāĄ─▓Į¾E╣╠Č©Ž┬üĒŻ¼├┐┤╬śŗ(g©░u)Į©Ģr(sh©¬)║“Š═ų╗ąĶę¬╗∙ė┌▀@éĆ(g©©)ńRŽ±į┘▀M(j©¼n)ąąį÷┴┐ą▐Ė─Š═┐╔ęį┴╦ĪŻĄ½▀@ĘNĘĮĘ©ŲõīŹ(sh©¬)ę▓ėąØōį┌å¢Ņ}Ż¼─ŪŠ═╩Ū«ö(d©Īng)╬ęéāąĶę¬╔²╝ē(j©¬)╗∙ĄA(ch©│)ńRŽ±Ą─Ģr(sh©¬)║“Ż¼▓╗Ą├▓╗ųžą┬śŗ(g©░u)Į©╦∙ėą╗∙ė┌╦³ųŲū„Ą─╦∙ėąĘ■äš(w©┤)ńRŽ±ĪŻ

▀@éĆ(g©©)å¢Ņ}▒╗ĘQ×ķĪ║┤Ó╚§Ą─╗∙ĄA(ch©│)ńRŽ±Ī╗Ż¼įōå¢Ņ}Ą─æ¬(y©®ng)ī”(du©¼)▓▀┬įėą║▄ČÓĪŻ└²╚ń║å(ji©Żn)å╬Ą─čė▀tūė╝ē(j©¬)ńRŽ±Ą─╔²╝ē(j©¬)Ģr(sh©¬)ķgŻ¼ų▒ĄĮ├┐éĆ(g©©)ūėńRŽ±Ž┬┤╬ųžą┬śŗ(g©░u)Į©░l(f©Ī)▓╝Ģr(sh©¬)ūį╚╗Ģ■(hu©¼)½@Ą├Ė³ą┬ĪŻėų└²╚ń▒╚▌^╝ż▀M(j©¼n)Ą─ĘĮ╩ĮŻ¼═©▀^┴„╦«ŠĆĮ©┴óńRŽ±Ą─ę└┘ćĻP(gu©Īn)ŽĄŻ¼į┌ĖĖ╝ē(j©¬)ńRŽ±ę╗Ą®Ė³ą┬Ģr(sh©¬)Ż¼ūįäė(d©░ng)ė|░l(f©Ī)╦∙ėąūė╝ē(j©¬)ńRŽ±Ą─ūįäė(d©░ng)ųžĮ©Ż¼▀@ĘNĘĮ╩Įę¬╔„ųž▓╔ė├Ż¼ę“?y©żn)ķ╦³║▄┐╔─▄Ģ?hu©¼)ī¦(d©Żo)ų┬═¼Ģr(sh©¬)«a(ch©Żn)╔·┤¾┴┐Ą─ńRŽ±śŗ(g©░u)Į©╚╬äš(w©┤)Ż¼ī”(du©¼)ŠW(w©Żng)Įj(lu©░)║═┤┼▒Pįņ│╔ć└(y©ón)ųžĄ─ē║┴”ĪŻ─Ū├┤Ż¼ėąø]ėąį┌ę╗ĘN▐kĘ©╝╚─▄½@Ą├Š▀ėąĢr(sh©¬)ą¦ąįĄ─Ė³ą┬Ż¼ėų▓╗Ģ■(hu©¼)«a(ch©Żn)╔·Č╠Ģr(sh©¬)ķgā╚(n©©i)Ą─śŗ(g©░u)Į©’L(f©źng)▒®─žŻ┐ŲõīŹ(sh©¬)ī”(du©¼)ė┌ę╗ą®ł÷(ch©Żng)Š░╩Ū┐╔ęįėą╚ĪŪ╔ĘĮĘ©Ą─Ż¼═©▀^DockerĄ─═ŌÆņ┤µā”(ch©│)─▄┴”Ż¼īóĮø(j©®ng)│Ż┐╔─▄ūā╗»Ą─ā╚(n©©i)╚▌ū÷│╔å╬¬Ü(d©▓)Ą─ńRŽ±Ż¼╚╗║¾└¹ė├DockerĄ─Ī║–volume-fromĪ╗ģóöĄ(sh©┤)į┌Ę■äš(w©┤)åóäė(d©░ng)Ģr(sh©¬)Ė▓╔wĄ¶▀\(y©┤n)ąą╚▌Ų„Ą─╠žČ©─┐õøĪŻĄõą═Ą─ł÷(ch©Żng)Š░Š═╩Ūė├ė┌ŠÄūgŲõ╦¹Ę■äš(w©┤)Ą─╚▌Ų„Ż¼▀@ą®╚▌Ų„ųąę╗░ŃČ╝Ģ■(hu©¼)ėąę╗ą®ŠÄūgĘ■äš(w©┤)Ģr(sh©¬)╦∙ąĶĄ─Ģr(sh©¬)ę└┘ćÄņŻ¼▀@ą®ę└┘ćÄņļSų°ĒŚ(xi©żng)─┐╦∙ąĶę└┘ćĄ─ūā╗»ę▓ę¬Ė·ų°ūāŻ¼Ž±MavenĄ─~/.m2/repository─┐õøŻ¼NodeĄ─╚½Šųnode_module─┐õøĄ╚Š═║▄▀m║Ž▀@śė╣▄└ĒĪŻ«ö(d©Īng)▀@éĆ(g©©)─┐õøŽ┬├µĄ─ā╚(n©©i)╚▌ąĶę¬Ė³ą┬Ģr(sh©¬)Ż¼ų╗ąĶųžą┬śŗ(g©░u)Į©╠ß╣®─┐õøā╚(n©©i)╚▌Ą─ę╗éĆ(g©©)ńRŽ±Ż¼Č°▓╗Ģ■(hu©¼)«a(ch©Żn)╔·ńRŽ±śŗ(g©░u)Į©Ą─µ£?zh©│n)ĮĘ┤æ?y©®ng)Ż¼Ę■äš(w©┤)Ž┬┤╬åóäė(d©░ng)Ģr(sh©¬)║“Š═Ģ■(hu©¼)½@Ą├ą┬Ą─ę└┘ćÄņ─┐õø┴╦ĪŻ

Ą┌Č■éĆ(g©©)└²ūė╩Ū┴„╦«ŠĆųąĄ─£y(c©©)įćŁh(hu©ón)╣Ø(ji©”)ĪŻ▀M(j©¼n)ąąūįäė(d©░ng)╗»£y(c©©)įćĄ─Ģr(sh©¬)║“Ż¼╚▌Ų„Ą─ā×(y©Łu)ä▌(sh©¼)░l(f©Ī)ō]ė╚Ųõ├„’@ĪŻī”(du©¼)ė┌═Ō▓┐Ę■äš(w©┤)Ą─ę└┘ćŻ¼▒╚╚ń┼cöĄ(sh©┤)ō■(j©┤)ÄņŽÓĻP(gu©Īn)Ą─£y(c©©)įćŻ¼ė╔ė┌£y(c©©)įć▀^│╠ąĶę¬Ę┤Å═(f©┤)▀\(y©┤n)ąąŻ¼▀^╚źĢr(sh©¬)║“Ż¼╚ń╣¹£y(c©©)įć▀\(y©┤n)ąą═Ļø]ėąš²┤_Ą─ŪÕ└Ē┴¶Ž┬Ą─öĄ(sh©┤)ō■(j©┤)Ż¼╠žäe╚▌ęūė░Ēæ║¾└m(x©┤)£y(c©©)įćĄ─▀\(y©┤n)ąąĮY(ji©”)╣¹ĪŻ╚▌Ų„ŪĪŪĪ╩Ū╠ß╣®▀@ĘN╝┤ė├╝┤Śē╗∙ĄA(ch©│)įO(sh©©)╩®ūŅ╝čĄ─ĘĮ╩ĮŻ¼═Ļ╚½┐╔ęįį┌£y(c©©)įć─_▒ŠųąŽ╚åóäė(d©░ng)ę╗éĆ(g©©)╚½ą┬Ą─MySQLĘ■äš(w©┤)Ż¼╚╗║¾£y(c©©)įć═ĻŠ═õNܦŻ¼▒ŻūC┴╦├┐┤╬£y(c©©)įćĄ─¬Ü(d©▓)┴óąįĪŻĻP(gu©Īn)ė┌▀@ĘĮ├µĄ─æ¬(y©®ng)ė├į┌Ž┬éĆ(g©©)░Ė└²ųąį┘ĮķĮBĖ³ČÓ╝Ü(x©¼)╣Ø(ji©”)ĪŻ

ŅÉ╦ŲĄ─╝╝Ū╔▀Ćėą║▄ČÓĪŻ│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆ╩ŪūŅ─▄¾w¼F(xi©żn)╚▌Ų„į┌▄ø╝■ŅI(l©½ng)ė“ĦüĒĖ„ĘĮ├µĖ─▀M(j©¼n)Ą─┤¾ė^ł@ĪŻįSČÓ¼F(xi©żn)│╔Ą─╣żŠ▀┐╔ęįūŅ┤¾╗»Ą─▒▄├Ō╩ų╣ż▓┘ū„ī”(du©¼)┴„│╠Ą─Ė╔ö_Ż¼ūī▄ø╝■░l(f©Ī)▓╝ķ_╔ŽĖ▀╦┘╣½┬ĘĪŻ

╚▌Ų„ų«Į³Ż║╚▌Ų„į┌ūįäė(d©░ng)╗»£y(c©©)įćŲĮ┼_(t©ói)Ą─▀\(y©┤n)ė├

łD4 ╗∙ė┌╚▌Ų„Ą─ūįäė(d©░ng)╗»£y(c©©)įćŲĮ┼_(t©ói)╝▄śŗ(g©░u)

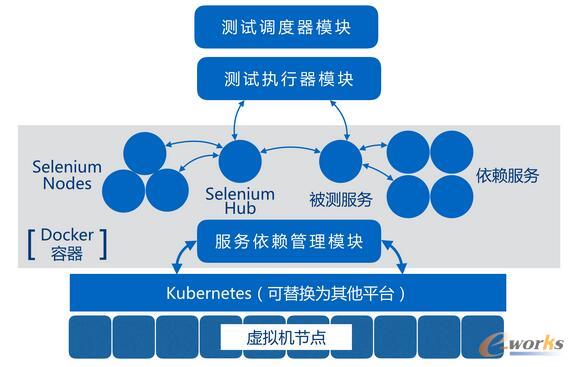

ūŅ║¾▀@éĆ(g©©)░Ė└²╩Ūę╗éĆ(g©©)ßśī”(du©¼)▄ø╝■ūįäė(d©░ng)╗»£y(c©©)įćŁh(hu©ón)╣Ø(ji©”)Ą─╚▌Ų„╗»╗∙ĄA(ch©│)įO(sh©©)╩®įO(sh©©)ėŗ(j©¼)ĪŻ╦³╩Ū▄ø╝■│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆ╔ŽĄ─ę╗éĆ(g©©)ųžę¬Łh(hu©ón)╣Ø(ji©”)Ż¼ūī╬ęéāĦ╔ŽķL(zh©Żng)Į╣ńRŻ¼Į³ŠÓļxīÅęĢ╚▌Ų„į┌▄ø╝■£y(c©©)įćł÷(ch©Żng)Š░ųą─▄ĮŌøQį§śėĄ─å¢Ņ}ĪŻ

╚▌Ų„┐ņ╦┘åóäė(d©░ng)Īó┐ņ╦┘õNܦĄ─╠žąį┼c▄ø╝■£y(c©©)įćĢr(sh©¬)╦∙ąĶĄ─├┐┤╬Ė╔ā¶¬Ü(d©▓)┴óĄ─┼RĢr(sh©¬)▀\(y©┤n)ąąŁh(hu©ón)Š│╩«ĘųŲź┼õĪŻ╩╣Ą├į┌▀@ĘĮ├µ╚▌Ų„┐╔ęį┤¾ėąū„×ķĪŻ╠žäe╩Ūį┌╝»│╔£y(c©©)įć║═╣”─▄ąį£y(c©©)įćĄ─ļAČ╬Ż¼▒╗£y(c©©)ŽĄĮy(t©»ng)Ą─▀\(y©┤n)ąą═∙═∙Ģ■(hu©¼)ąĶę¬╔µ╝░ČÓéĆ(g©©)ꬬÜ(d©▓)┴ó▀\(y©┤n)ąąĄ─ūėĮM╝■╗“ūė─ŻēKĪŻ▀Ćėą═Ō▓┐─ŻēKĄ─ę└┘ćŻ¼╚ń╣¹▀M(j©¼n)ąąĄ─╩ŪĮń├µŽÓĻP(gu©Īn)Ą─£y(c©©)įćė├└²Ż¼═∙═∙▀ĆĢ■(hu©¼)ė├ĄĮSelenium║═×gė[Ų„Ą─ĮM╝■ĪŻČ°▀\(y©┤n)ąąöĄ(sh©┤)ō■(j©┤)ÄņŽÓĻP(gu©Īn)Ą─£y(c©©)įćätĢ■(hu©¼)ąĶę¬MySQLĪóMongodbĄ╚ĮM╝■ĪŻ╩ų╣ż×ķ├┐éĆ(g©©)£y(c©©)įćė├└²£╩(zh©│n)éõ▓óŠSūo(h©┤)▀@ą®Łh(hu©ón)╣Ø(ji©”)ę└┘ć╩Ū╩«Ęųūī╚╦ūź┐±Ą─╩┬ŪķĪŻ▀^╚źū÷▀@ŅÉ£y(c©©)įćĢr(sh©¬)║“?y©żn)ķ┴╦ĮŌøQę└┘ćå¢Ņ}Ż¼═©│Żū÷Ę©╩ŪŅ~═Ō▓┐╩ę╗╠ūīŻė├ė┌£y(c©©)įćę└┘ćĄ─Łh(hu©ón)Š│Ż¼╦∙ėą─ŻēK£y(c©©)įćąĶę¬?ji©Żng)eĄ──ŻēKĢr(sh©¬)Č╝Įy(t©»ng)ę╗ųĖŽ“▀@╠ū£y(c©©)įćŁh(hu©ón)Š│ū„×ķ─┐ś╦(bi©Īo)ĪŻė╔ė┌▀^ė┌ŅlĘ▒Ą─╔²╝ē(j©¬)▀@éĆ(g©©)ę└┘ćŁh(hu©ón)Š│┐╔─▄Ģ■(hu©¼)┤“öÓš²į┌▀\(y©┤n)ąąĄ─£y(c©©)įćė├└²Ż¼ę“┤╦ų╗─▄ī”(du©¼)╦³▀M(j©¼n)ąąČ©Ų┌Ą─Ė³ą┬Ż¼▀@ĘN¤oą╬ųąŽ▐ųŲ┴╦Ą─Ģr(sh©¬)ą¦ąį║═┐╔┐┐ąįĪŻ

╠žäe╩Ūę╗ą®▒╚▌^ųžę¬▓óŪę║─Ģr(sh©¬)▌^Č╠Ą─╗žÜw£y(c©©)įć║═├░¤¤£y(c©©)įćė├└²Ż¼└ĒŽļŪķørŽ┬æ¬(y©®ng)įōį┌├┐┤╬┤·┤a╠ßĮ╗║¾Č╝╚½┴┐Ą─Ė³ą┬▓ół╠(zh©¬)ąąŻ¼ęį▒ŃĄ┌ę╗Ģr(sh©¬)ķg░l(f©Ī)¼F(xi©żn)ę╗ą®Øōį┌Ą─╣”─▄╚▒Ž▌ĪŻĄ½×ķ├┐┤╬╠ßĮ╗äō(chu©żng)Į©ę╗╠ū£y(c©©)įćŁh(hu©ón)Š│▓╗šō╩Ū╩ų╣ż▓┘ū„▀Ć╩Ū▀^╚ź╗∙ė┌╠ōöMÖC(j©®)Ą─ūįäė(d©░ng)╗»ĘĮ╩ĮČ╝▀^ė┌Ę▒¼ŹĪŻ

░Ė└²ųąĄ─£y(c©©)įćŲĮ┼_(t©ói)š²╩ŪęŌłD═©▀^╚▌Ų„║═║å(ji©Żn)å╬Ą─ę└┘ć├Ķ╩÷Ż¼üĒĮŌøQ£y(c©©)įćŁh(hu©ón)Š│╣▄└ĒĄ─å¢Ņ}ĪŻ╦³╗∙ė┌╦∙ėą▒╗£y(c©©)ĮM╝■║═╦∙ę└┘ćĄ─ĮM╝■Č╝╩╣ė├DockerńRŽ±üĒ╠ß╣®Ą─Ū░╠ßų«╔ŽŻ¼īó╦∙ėąĮM╝■│ķŽ¾│╔ę╗ų┬Ą──Żą═īæ│╔├Ķ╩÷╬─╝■Ż¼├Ķ╩÷╬─╝■Ą─ų„ę¬ā╚(n©©i)╚▌Š═╩Ūš¹éĆ(g©©)£y(c©©)įćŁh(hu©ón)Š│╦∙ąĶĄ─ńRŽ±║═åóäė(d©░ng)Ēśą“ĪŻ

╩ŠęŌłDųąĄ─Ī║▀\(y©┤n)ąąš{(di©żo)Č╚Ų„─ŻēKĪ╗╩ŪĮė╚ļ│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆĄ─š{(di©żo)ė├╚ļ┐┌Ż¼┐╔ęį▓╔ė├Ų®╚ńJenkinsĄ─ą╬╩Į▓Õ╝■īŹ(sh©¬)¼F(xi©żn)Ż¼╦³ė├üĒäō(chu©żng)Į©║═▒Ż┤µ╠žČ©£y(c©©)įćė├└²╦∙ąĶĄ─Łh(hu©ón)Š│├Ķ╩÷╬─╝■ā╚(n©©i)╚▌ĪŻį┌┴„╦«ŠĆė|░l(f©Ī)įō£y(c©©)įćŁh(hu©ón)╣Ø(ji©”)Ģr(sh©¬)Ż¼▀@éĆ(g©©)─ŻēKš{(di©żo)ė├Ī║£y(c©©)įćł╠(zh©¬)ąąŲ„─ŻēKĪ╗Ż¼īó├Ķ╩÷─Żą═ė├╠žČ©Ą─ĮY(ji©”)śŗ(g©░u)¾wé„▀fĮo║¾š▀Ż¼║¾š▀ĮŌ╬÷▀@éĆ(g©©)öĄ(sh©┤)ō■(j©┤)─Żą═Ż¼▐D(zhu©Żn)╗»×ķĮėĮ³KubernetesĘ■äš(w©┤)─Żą═Ą─ą╬╩ĮŻ¼╚╗║¾į┌Ī║Ę■äš(w©┤)ę└┘ć╣▄└Ē─ŻēKĪ╗Ą─ģf(xi©”)ų·Ž┬Ż¼═©▀^Kubernetesäō(chu©żng)Į©┼RĢr(sh©¬)Ą─NamespaceŻ¼▓óę└┤╬äō(chu©żng)Į©├┐éĆ(g©©)Ę■äš(w©┤)ĪŻ«ö(d©Īng)£y(c©©)įćŁh(hu©ón)Š│Š═Šw║¾Ż¼Ī║£y(c©©)įćł╠(zh©¬)ąąŲ„─ŻēKĪ╗Š═ķ_╩╝ł╠(zh©¬)ąą£y(c©©)įćė├└²Ż¼ūŅ║¾ėų═©▀^Ī║Ę■äš(w©┤)ę└┘ć╣▄└Ē─ŻēKĪ╗═©ų¬KubernetesõNܦš¹╠ūŁh(hu©ón)Š│ĪŻ

š¹éĆ(g©©)▀^│╠ī”(du©¼)ė┌ŲĮ┼_(t©ói)Ą─ė├æ¶Č°čįŻ¼āHāH╩Ūį÷╝ė┴╦ę╗éĆ(g©©)£y(c©©)įćŁh(hu©ón)Š│├Ķ╩÷Ą─ā╚(n©©i)╚▌Ż¼īæį┌│ų└m(x©┤)Į╗ĖČ┴„╦«ŠĆ£y(c©©)įć▓Į¾EĄ─Č©┴x(└²╚ńJenkins▓Õ╝■┼õų├)└’ĪŻČ°▀@╠ūŽĄĮy(t©»ng)ā╚(n©©i)▓┐ŅH×ķÅ═(f©┤)ļsĄ─ł╠(zh©¬)ąą▀^│╠Ż¼─▄ē“ėąą¦Ą─└¹ė├š¹éĆ(g©©)╝»╚║Ą─┘Yį┤Ż¼ŪĪĄĮ║├╠ÄĄ─×ķ£y(c©©)įćĄ─▀^│╠╠ß╣®ų¦│ųĪŻ

┐éĮY(ji©”)

▀@╦─éĆ(g©©)░Ė└²ė╔£\╚ļ╔ŅĪóė╔▀h(yu©Żn)╝░Į³Ą─š╣¼F(xi©żn)┴╦╚▌Ų„į┌¼F(xi©żn)┤·▄ø╝■║═╗∙ĄA(ch©│)įO(sh©©)╩®įO(sh©©)ėŗ(j©¼)ųą┼eūŃ▌pųžĄ─ū„ė├ĪŻėąą®╝╝ąg(sh©┤)Ģ■(hu©¼)ų▒ĮėĖ─ūā?n©©i)╦éāĄ─╔·╗ŅŻ¼Č°┴Ēę╗ą®╝╝ąg(sh©┤)ätĢ■(hu©¼)Ė─ūā╝╝ąg(sh©┤)▒Š╔Ēęį╝░╝╝ąg(sh©┤)Ą─░l(f©Ī)š╣ĘĮŽ“Ż¼╚▌Ų„╝╝ąg(sh©┤)ī┘ė┌║¾š▀ĪŻ

ļSų°╚▌Ų„▀\(y©┤n)ė├Ą─Ųš╝░Ż¼«ö(d©Īng)Ž┬Ą─ų„┴„├Į¾wī”(du©¼)╚▌Ų„ų▄▀ģ╝╝ąg(sh©┤)Ą─ĻP(gu©Īn)ūó▀Ćį┌│ų└m(x©┤)╔²£žĪŻ▓╗āH╩ŪĪČ│╠ą“åTĪĘ═Ų│÷┴╦▒ŠŲ┌Ą─╚▌Ų„╝╝ąg(sh©┤)īŻ┐»Ż¼į┌ūŅą┬ę╗Ų┌Ą─ThoughtWorks╣½ķ_┐»╬’ĪČ╝╝ąg(sh©┤)└ū▀_(d©ó)ĪŠ1Ī┐ĪĘųąŻ¼╚▌Ų„║═DockerŽÓĻP(gu©Īn)Ą─ĻP(gu©Īn)µIį~═¼śėš╝ō■(j©┤)┴╦┤¾┴┐░µ├µĪŻį┌įĮüĒįĮČÓĄ─╝╝ąg(sh©┤)ŅI(l©½ng)ė“└’Ż¼¤ošō╩ŪęŲäė(d©░ng)įO(sh©©)éõĪó

╬’┬ō(li©ón)ŠW(w©Żng)Īó┤¾öĄ(sh©┤)ō■(j©┤)Ż¼Č╝─▄┐┤ĄĮ╚▌Ų„╝╝ąg(sh©┤)Ė„ĘNą╬╩ĮĄ─čė╔ņŻ¼ū„×ķ¼F(xi©żn)īŹ(sh©¬)╚▌Ų„▀\(y©┤n)ė├Ą─ę╗Ą└┐sė░Ż¼┤╦╬─┐╔ū„×ķĖQ░▀ęŖ▒¬ĪóÆü┤uę²ė±ų«ė├ĪŻ

║╦ą─ĻP(gu©Īn)ūóŻ║═ž▓ĮERPŽĄĮy(t©»ng)ŲĮ┼_(t©ói)╩ŪĖ▓╔w┴╦▒ŖČÓĄ─śI(y©©)äš(w©┤)ŅI(l©½ng)ė“ĪóąąśI(y©©)æ¬(y©®ng)ė├Ż¼╠N(y©┤n)║Ł┴╦žSĖ╗Ą─ERP╣▄└Ē╦╝ŽļŻ¼╝»│╔┴╦ERP▄ø╝■śI(y©©)äš(w©┤)╣▄└Ē└Ē─ŅŻ¼╣”─▄╔µ╝░╣®æ¬(y©®ng)µ£Īó│╔▒ŠĪóųŲįņĪóCRMĪóHRĄ╚▒ŖČÓśI(y©©)äš(w©┤)ŅI(l©½ng)ė“Ą─╣▄└ĒŻ¼╚½├µ║Ł╔w┴╦Ų¾śI(y©©)ĻP(gu©Īn)ūóERP╣▄└ĒŽĄĮy(t©»ng)Ą─║╦ą─ŅI(l©½ng)ė“Ż¼╩Ū▒ŖČÓųąąĪŲ¾śI(y©©)ą┼Žó╗»Į©įO(sh©©)╩ū▀xĄ─ERP╣▄└Ē▄ø╝■ą┼┘ćŲĘ┼ŲĪŻ

▐D(zhu©Żn)▌dšł(q©½ng)ūó├„│÷╠ÄŻ║═ž▓ĮERP┘YėŹŠW(w©Żng)http://www.guhuozai8.cn/

▒Š╬─ś╦(bi©Īo)Ņ}Ż║¼F(xi©żn)īŹ(sh©¬)ųąĄ─╚▌Ų„╝╝ąg(sh©┤)▀\(y©┤n)ė├░Ė└²

▒Š╬─ŠW(w©Żng)ųĘŻ║http://www.guhuozai8.cn/html/support/11121819995.html